AI tuân lệnh con người, có ổn không?

Bằng việc dạy cho các cỗ máy hiểu những mong muốn của chúng ta, có nhà khoa học hi vọng sẽ tránh được khả năng gây ra những hậu quả nghiêm trọng khi chúng nghe theo hiệu lệnh của con người.

Trí tuệ nhân tạo có năng lực mạnh mẽ nhưng cũng có thể ngốc nghếch như thần đèn trong chai. Giả sử chúng ta sai chúng một điều vô hại như “xây cho tôi một ngôi nhà thân thiện với môi trường” thì nó có thể gây ra những hậu quả khôn lường khi thực hiện.

Khi muốn AI làm cho chúng ta một điều gì đó, rất có thể chúng ta sẽ có lúc bất cẩn viết ra những dòng “code” (dòng lệnh) không rõ ngữ cảnh, không nêu ra cảnh báo và cuối cùng sẽ tạo ra những mục tiêu và động cơ nhiệm vụ cho AI thực hiện không giống như mong muốn ban đầu của chúng ta.

Nhà triết học Nick Bostrom từ Oxford đã đưa ra một thí nghiệm tư duy cổ điển cho vấn đề này vào năm 2003. Bostrom tưởng tượng ra một robot siêu trí tuệ, được lập trình với mục tiêu dường như vô hại để sản xuất ra kẹp giấy. Robot cuối cùng biến cả thế giới thành một nhà máy sản xuất kẹp giấy khổng lồ.

Những chuyện như vậy từng được coi là không thể trong giới khoa học nhưng thực sự thì mối lo này có thể đến rất nhanh. Những robot AI không được kiểm soát giờ đây đang trở thành vấn đề nghiêm trọng sớm hơn chúng ta nghĩ.

Một ví dụ đáng báo động nhất là YouTube, nền tảng công nghệ có thể ảnh hưởng đến cả tỷ người. Với mong muốn cho người dùng cơ hội xem nhiều video nhất có thể, YouTube triển khai các thuật toán AI “mồi chài” chúng ta xem hết cái này đến cái khác. Khoảng hai năm trước, các nhà khoa học và người dùng đã bắt đầu nhận thấy sự hiện diện của các thuật toán YouTube: để thu hút người dùng, nền tảng này đã “mời mọc” người dùng xem những nội dung ngày càng cực đoan. Một nạn nhân kể lại khi cô ấy xem đoạn phim về các cuộc biểu tình trong chiến dịch ứng cử Tổng thống của ông Donald Trump thì sau đó YouTube đã khuyến nghị những clip như sự tán dương siêu nhân trắng, phủ nhận các cuộc thảm sát (Holocaust) hay các nội dung đáng lo ngại khác. Những thuật toán kiểu vẫn được ví von là “liều ăn nhiều” (upping-the-ante) như vậy không chỉ diễn ra trong các đề tài liên quan đến chính trị mà còn lan sang nhiều lĩnh vực khác, ví dụ như video về ăn chay đi kèm với các video về chủ nghĩa thuần chay, video về chạy bộ lại dẫn đến các video về chạy marathon siêu nặng. Kết quả là YouTube đã tạo ra sự phân cực và nhiều khi truyền bá thông tin sai lệch chỉ để đạt mục đích là giữ chân người dùng. Dylan Hadfield-Menell, một nhà nghiên cứu AI tại Đại học California, Berkeley, cho biết nếu ở trong giai đoạn thử nghiệm, anh cũng không triển khai công nghệ mang tính “dẫn dụ” ở quy mô lớn như thế này.

Các kỹ sư của YouTube có lẽ đã không có ý định đem đến khái niệm phân biệt chủng tộc cho nền tảng công nghệ này nhưng đơn giản là họ không thể hình dung hết được mọi thứ mà các thuật toán của họ sẽ tác động đến. “Cách chúng ta đang làm AI đã bắt đầu tạo ra một gánh nặng cho các nhà thiết kế hệ thống là làm sao hiểu hết được hệ quả của những sáng tạo khi họ viết chương trình AI”, Hadfield-Menell cho biết. “Và chúng ta biết chắc một điều là rất nhiều kỹ sư đã mắc lỗi khi lập trình.”

Một vấn đề nghiêm trọng khác là trong nhiều trường hợp thì chính chúng ta cũng không biết chúng ta thực sự nghĩ gì, nên cũng không biết chỉ gì cho hệ thống AI.

“Bạn thử hỏi ai đó trên đường là một chiếc xe tự lái cần phải làm gì?” Họ sẽ nói ngay là phải tránh tai nạn. Dorsa Sadigh, một nhà khoa học trí tuệ nhân tạo tại Stanford chuyên về tương tác người – máy cho biết. Thế nhưng rõ ràng không chỉ có vậy mà còn có rất nhiều điều cần quan tâm khác. Một chiếc xe tự lái siêu an toàn sẽ đi quá chậm, phanh nhiều đến mức làm cho người đi say xe đến phát ốm. Nếu lập trình viên viết ra danh sách những nội dung xe tự lái phải đạt được thì danh sách sẽ kéo dài vô tận. Sadigh kể rằng khi lái xe ở San Francisco, cô thường bị một vài chiếc tự lái đi chậm như rùa “chắn mặt”. Đúng là người ta lập trình cho nó để tránh các vật chuyển động, thế nên nó đi chậm như một cái túi nilon bay lờ đờ trong gió.

Nên để tránh những vấn đề này và đạt được các mục tiêu của bài toán AI, các nhà nghiên cứu đã bắt đầu phát triển một phương pháp mới về lập trình có ích. Phương pháp này rất giống với ý tưởng và những nghiên cứu của Stuart Russell, một nhà khoa học máy tính nổi tiếng ở Berkeley. Russell, 57 tuổi, đã có nhiều công trình về tính hiệu quả, quá trình ra quyết định và học máy suốt những năm 1980 và 1990. Ông cũng là tác giả chính của cuốn sách phổ biến “Artificial Intelligence: A Modern Approach” (Trí tuệ nhân tạo: Một cách tiếp cận hiện đại). Khoảng 5 năm trở lại đây, ông là một diễn giả nổi tiếng và có nhiều ảnh hưởng về những vấn đề quy tắc của AI. Với bộ complet đen, nhân vật người Anh giỏi diễn thuyết này thường xuyên là tâm điểm của các cuộc hội thảo quốc tế bàn về rủi ro và cách quản lý AI trong dài hạn.

Khoảng 5 năm trở lại đây, Stuart Russell là một diễn giả nổi tiếng và có nhiều ảnh hưởng về những vấn đề quy tắc của AI.

Russel cho rằng cách tiếp cập tối ưu cho một “hàm mục tiêu” như của AI hiện nay khá giới hạn, mặc dù nó đã đạt được nhiều thành công như chơi thắng con người trong trò chơi Jeopardy, trò chơi cờ Vây, nhận diện đồ vật trong ảnh, nhận dạng từ hay thậm chí sáng tác nhạc hay văn xuôi. Việc bắt máy đi tối ưu một hàm mục tiêu – chỉ là một mô tả chi tiết các mục tiêu khác nhau của bài toán sẽ có thể tạo ra những AI không đúng hướng. Bởi vì chúng ta không thể nào đưa hết và đặt đúng trọng số cho tất cả các mục tiêu, mục tiêu con, ngoại lệ hay phản đối trong cùng một hàm mục tiêu. Đúng hơn là chính chúng ta cũng không biết hết. Nếu để cho các mục tiêu khi lập trình thay đổi tự do như vậy, các robot “tự điều khiển” sẽ trở nên rủi ro hơn nếu chúng thông minh hơn. Bởi vì chúng sẽ đi tìm kiếm các hàm mục tiêu một cách không khoan nhượng và thậm chí là không cho con người chúng ta tắt chúng đi nữa.

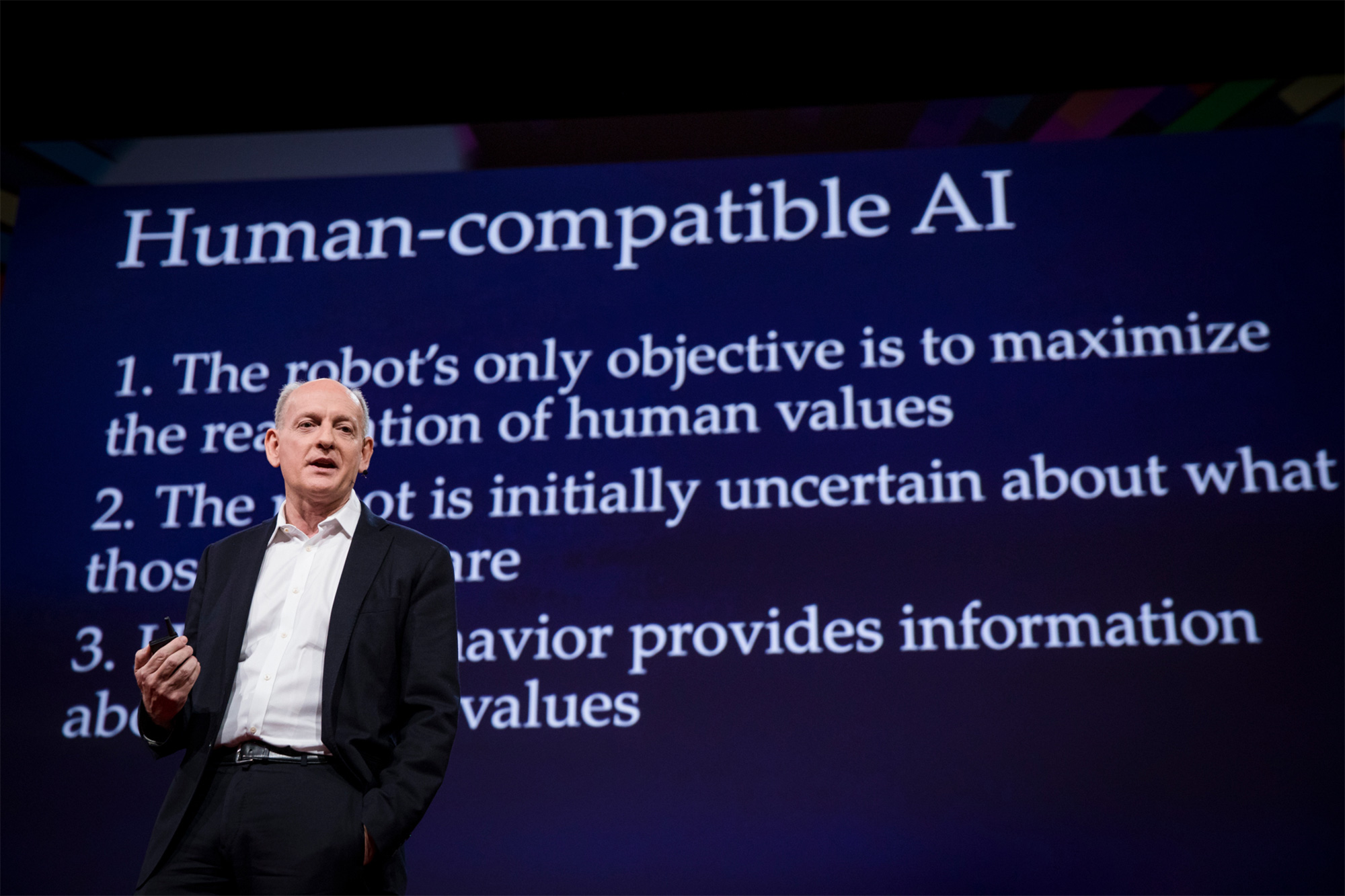

Thay vì để các cỗ máy theo đuổi các mục tiêu của chính chúng, cách tiếp cận mới là chúng cần tìm cách thỏa mãn các mong muốn của con người; mục tiêu duy nhất của chúng là phải học để hiểu các mong muốn của chúng ta. Russsel cho rằng, nếu những mong muốn của chúng ta có tính bất định hơn và các robot AI phải rõ hơn về mong muốn đó thì chúng sẽ trở nên an toàn hơn. Trong cuốn sách gần đây của mình, “Human Compatible” (Con người tương thích), Russell đưa ra luận điểm của mình dưới dạng ba nguyên tắc của những cỗ máy có lợi, giúp chúng ta gợi nhớ về ba định luật robot của giáo sư hóa sinh kiêm nhà văn khoa học viễn tưởng Isaac Asimov từ năm 1942 nhưng ít ngây thơ hơn. Russell viết:

1. Mục tiêu duy nhất của máy móc là tối đa hóa việc thực hiện những mong muốn của con người.

2. Ban đầu máy móc không chắc chắn về mong muốn của con người là gì.

3. Nơi để tìm kiếm thông tin cuối cùng về mong muốn của con người là hành vi của con người.

Trong vài năm qua, Russell và nhóm nghiên cứu của ông tại Berkeley cũng như những nhóm khác có cùng chí hướng ở Standford, ĐH Texas… đang phát triển những cách thức mới để gắn các hệ AI hướng đến mong muốn của con người nhưng lại không cần chỉ rõ ra các mong muốn đó.

Các lab này đang dạy cho robot cách học những mong muốn của con người mà con người không bao giờ nói rõ chúng hay còn không chắc chắn về những gì họ muốn. Các robot sẽ học mong muốn của chúng ta bằng cách quan sát những cử chỉ và hành vi không hoàn hảo, chúng thậm chí còn sáng tạo ra những hành vi mới khi chính con người chúng ta còn mơ hồ, ví dụ, ở các ngã tư, xe tự lái đã học ra cách lùi lại một chút để báo hiệu cho người lái xe đi trước. Những kết quả này cho thấy AI có thể học và suy luận rất tốt mong muốn của chúng ta, thậm chí ngay cả khi chúng ta đang cho nó học.

Trong lab của Scott Niekum tại Đại học Texas, Austin, một robot tên Gemini đã học được cách đặt một lọ hoa vào giữa bàn.

Sadigh nói “Đây là những nỗ lực đầu tiên để xác định vấn đề” và “cũng chỉ mới gần đây con người mới nhận ra được sự cần thiết phải nghiên cứu tương tác người-máy một cách cẩn trọng hơn.”

Liệu những nỗ lực mới và ba nguyên tắc của Russell có mở ra một tương lai tươi sáng cho AI hay không thì còn cần chờ đợi. Nhưng cách tiếp cận này đã đánh dấu một cột mốc về việc robot có khả năng hiểu con người thực sự mong muốn gì. Một thứ mà các robot đã cố gắng tìm ra trong một thời gian trước. Paul Christiano, một nhà nghiên cứu cùng hướng tại OpenAI, cho biết ít nhất thì Russell và nhóm của ông đã nêu ra rất rõ bài toán và giúp “chỉ ra hành vi mà robot cần làm là như thế nào – đó cũng là những gì chúng tôi hướng đến.”

Làm sao để hiểu con người?

Những ý tưởng của Russel thể hiện sự thông minh đặc biệt, nó đến với ông vào năm 2014 khi đi trao đổi về khoa học ở Paris, và lúc ông đi tập ở một dàn hợp xướng (ông hát giọng nam cao). Ông nhớ lại “bởi vì tôi không giỏi nhạc lắm nên tôi phải luyện trước trong metro khi trên đường tới buổi tập”. Ông nghe bản Agnus Dei của Samuel Barber viết năm 1967 trong lúc đi tàu điện ngầm dưới kinh đô ánh sáng. “Bản nhạc thật hay, thật kỳ lạ là nó gợi lên trong tôi vấn đề và mục đích của AI là gì, và hiểu theo một cách nào đó thì AI phải là tổng hòa của những trải nghiệm của con người”, Rusell nói.

Robut không tìm cách đạt được mục đích kiểu tối ưu thời gian xem hay sản xuất kẹp giấy nhiều nhất, AI phải đơn giản là làm cho cuộc sống con người tốt đẹp hơn. Câu hỏi đặt ra là “để bắt máy móc tối ưu ‘tổng hòa của những trải nghiệm của con người’ thì cụ thể con người làm gì để chúng có thể hiểu được?”

(Trong lab của Scott Niekum tại Đại học Texas, Austin, một robot tên Gemini học cách đặt một lọ hoa vào giữa bàn. Con người chỉ cho nó một cách không rõ ràng, hoặc có thể là đặt lọ hoa vào bên phải đĩa xanh, hoặc vào bên trái tô màu đỏ. Cuối cùng sau khi quan sát một số cử chỉ, robot đã học và làm tốt.)

Những ý tưởng của Russel đã bắt nguồn từ khá lâu. Ông học AI từ trong trường ở London vào những năm 1970, khi đó lập trình các thuật toán chơi tic-tac-toe và chơi cờ trên máy tính của một trường đại học gần đó. Về sau, khi chuyển đến vùng chuyên về AI là Bay Area ông bắt đầu nghiên cứu về quá trình ra quyết định hợp lý của con người. Ông nhận ra ngay là điều này không thể có được. Con người không hành xử hợp lý lắm đâu, bởi vì để hành xử hợp lý cần lượng tính toán khổng lồ không khả thi: Chúng ta không thể nào tính toán ra được ở mỗi thời điểm cần làm hành động gì để tạo ra lợi ích tối đa trong tương lai trong số hàng ngàn tỷ hành động; và AI cũng không thể tính được. Russell đưa ra giả thuyết rằng việc ra quyết định của con người có tính phân cấp – chúng ta xấp xỉ hợp lý các hành động trong khi theo đuổi các mục tiêu dài hạn khá rộng, thông qua các mục tiêu trung hạn và chú ý nhất đến hoàn cảnh ngắn hạn ngay trước mắt. Các robot cũng sẽ cần phải làm một cái gì đó tương tự hoặc ít nhất là hiểu cách chúng ta vận hành, ông nói.□

(Còn tiếp)

Nguyễn Quang dịch

Nguồn: https://www.quantamagazine.org/artificial-intelligence-will-do-what-we-ask-thats-a-problem-20200130/