Câu hỏi này được đặt ra vì hiện nay, các hệ AI vẫn còn nhiều hạn chế, đặc biệt về hiệu suất tính toán và tiêu thụ năng lượng. Ví dụ như bộ não con người chỉ tiêu thụ một công suất khoảng 20W thì một hệ thống AI có khả năng suy nghĩ như não người (hiện chưa có) được dự đoán sẽ cần tiêu thụ một lượng điện năng lớn hơn ít nhất 1 triệu lần não người nếu dựa trên kiến trúc hiện tại. Xa hơn, các hệ AI cần thêm các khả năng thông minh trừu tượng hơn (so với việc thực hiện xử lý thông tin trực tiếp từ các giác quan, hay phản xạ, tối ưu,...) như phát kiến, sáng tạo, đức tin, tính cách... mà cấu trúc hiện nay còn hạn chế. Trong bối cảnh đó, các hệ AI mới cần được chế tạo trên những vật liệu thực, với các cấu phần chính của chúng (neuron, liên kết giữa các neuron) là các thực thể vật chất thì mới có thể đạt được hiệu suất vượt trội. Chúng tôi tạm gọi các hệ tiềm năng đó là "các hệ tính toán tự nhiên phục vụ AI", với các nguyên lý của các ngành khoa học tự nhiên khác là cơ chế hoạt động chính.

AI học hỏi não người

Một hệ thông minh tự nhiên có thể được coi là một hệ mà các cấu phần của nó là các thực thể tự nhiên tương tác với nhau và tạo ra sự tính toán thông minh. Bộ não là một hệ thông minh tự nhiên hoàn hảo. Các hệ AI hiện tại phần lớn là một sự mô phỏng lại sơ bộ cấu trúc sinh học của bộ não bởi các máy tính (dưới dạng phần mềm), chúng không phải tự nhiên và chính là nguồn gốc của chữ A (artificial). Khi bộ nhớ bị xóa hết, máy tính tắt thì hệ AI đó không còn tồn tại. Tính toán AI qua mô phỏng hạn chế ở chỗ: mọi tính toán giữa các neuron thực chất phải truyền về nơi tính toán của máy tính là CPU/GPU với số lượng hạn chế so với số thành phần (neuron, khớp thần kinh) cần tính toán, cùng với năng lượng tiêu thụ lớn hơn. Các hệ thông minh tự nhiên chế tạo trên các vật chất thực có được lợi điểm lớn nhất là: tính toán trên chính các thực thể vật chất (như neuron trong não), không phụ thuộc vào CPU/GPU bên ngoài. Các tính toán như vậy sẽ diễn ra với tốc độ ánh sáng và tiêu thụ rất ít năng lượng.

Với gần 100 tỷ neuron và 100 ngàn tỷ khớp thần kinh, não người là một bộ máy vô cùng phức tạp. Sự phức tạp nằm ở các kết nối còn thành phần cấu tạo thì lại đơn giản với ba thành phần chính: neuron, dây thần kinh, khớp thần kinh. Hình 1a mô phỏng một cấu trúc neuron với rất nhiều xúc tua (dendrite) là nơi nhận các tín hiệu từ các neuron đi tới nó. Nhân của neuron là nơi tổng hợp lại các tín hiệu đến và thực hiện chức năng phát (fire) nếu tổng tín hiệu đến đạt đủ một ngưỡng nào đó. Có thể mô tả chức năng của neuron gồm một phép cộng (+) tín hiệu và một phép biến đổi phi tuyến f (sẽ giải thích rõ hơn ở phần sau). Tín hiệu mà nhân phát ra được truyền qua duy nhất một dây thần kinh (axon) và điểm cuối của axon kết nối với xúc tua của một hay nhiều neuron khác. Chỗ kết nối này là một nơi rất quan trọng, nó có điện trở có thể thay đổi được dựa trên việc tín hiệu chạy qua nhiều hay ít, mạnh hay nhẹ, trước hay sau bao lâu. Giá trị điện trở đó theo ngôn ngữ AI gọi là trọng số (w) của hai kết nối neuron-neuron và chứa đựng mọi kiến thức của con người. Trong ngôn ngữ thần kinh kết nối này được gọi là synapse 1. Hình 1c biểu diễn sự kết nối của nhiều neuron với nhau và hình 1b là một hình ảnh mô phỏng sự kết nối giữa các neuron thực, với màu đỏ là nhân neuron và các điểm sáng là khớp nối synapse. Ở hình 2 chúng ta được thấy một bức tranh tổng thể của một não ruồi do Google mới chụp lại đầu năm 2020, thể hiện tất cả 25,000 neuron và 25 triệu khớp nối của ruồi. Nói tóm lại, có thể mô hình một cấu trúc não sinh học như là một tổ hợp gồm hai thành phần quan trọng nhất bao gồm 2:

Nhân neuron (gọi tắt là neuron) thực hiện phép + tín hiệu và cơ chế phát theo ngưỡng f.

Khớp nối (synapse) cho phép truyền tín hiệu qua nhiều hay ít, nhanh hay chậm dựa trên điện trở của chúng. Chúng ta mô tả chức năng này bằng phép nhân ×.

Các ứng dụng AI hiện đại nhất hiện nay dựa trên các mô hình học sâu Deep Learning đều mô phỏng lại mô hình này một cách nào đó. Hình 3a biểu diễn một mạng Deep Learning với các lớp neuron cách biệt nhau. Các neuron trong một lớp chỉ nhận tín hiệu từ các neuron của lớp trước và chỉ phát tín hiệu đến các neuron của lớp sau. (Đây là một sự đơn giản hóa bởi với hình số 2, chúng ta có thể tưởng tượng được tín hiệu không truyền theo lớp tách biệt như thế trong cấu trúc sinh học.)

Có thể mô tả chi tiết hơn bằng công thức các hoạt động của neuron và synapse, trong đó tín hiệu phát ra từ neuron 0 ký hiệu x0 qua sợi trục (axon) của chính nó; tín hiệu truyền đến khớp nối (synapse) có độ dẫn điện w0, trở thành w0 x0; tín hiệu tiếp tục đi vào xúc tua (dendrite) của neuron chính đang xét (vòng tròn xanh); các tín hiệu tương tự w1 x1, w2 x2 từ các neuron khác cũng truyền đến neuron chính; neuron chính thực hiện phép cộng các tín hiệu từ các neuron khác, cộng thêm một điện thế đặc trưng của chính nó b tạo thành tín hiệu vào; neuron chính thực hiện cơ chế phát theo ngưỡng, phát ra một xung điện nếu tín hiệu vào vượt qua một ngưỡng nào đó. Cơ chế này được mô tả bằng một hàm kích hoạt (activation function) f tạo thành tín hiệu phát ra axon (giống như neuron 0 ban đầu).

Hình 3: a) Sơ đồ mạng neuron học sâu với 2 lớp ẩn b) mô tả toán học của một neuron và synapse (Image credit: CS231n)

Tín hiệu của não bộ của chúng ta cũng được truyền đi theo cách tương tự như vậy. Ví dụ khi nhìn thấy một con mèo, ánh sáng từ mèo được chiếu vào các tế bào giác mạc của mắt, chuyển thành tín hiệu điện truyền qua các dây thần kinh thị giác chứa các khớp nối hay synapse. Do các synapse có giá trị điện trở định sẵn, tín hiệu hình ảnh của con mèo sẽ tạo ra những dòng điện khác nhau tại những neuron khác nhau ở lớp trung gian. Cuối cùng, tín hiệu được truyền đến các dây thần kinh và neuron vùng nhận thức, ở đó các neuron tương ứng với phần nhận thức đây là con mèo, được kích hoạt mạnh nhất. Đây chính là quá trình xác định hay suy diễn (inference), quá trình này chúng ta sử dụng các giá trị điện trở có sẵn của các synapse.

Vấn đề là làm sao có được các giá trị giá trị điện trở synapse phù hợp ở vùng trung gian và ở vùng nhận thức để tạo ra những neuron tương ứng với khái niệm con mèo? Đó chính là quá trình học của mạng neuron cũng như của não người. Có thể coi quá trình học, cả của mạng nhân tạo và mạng sinh học, là quá trình xác định nên các giá trị khớp nối synapse phù hợp.

Trong não bộ, các giá trị khớp nối được điều chỉnh qua mỗi quá trình quan sát và thực hành. Ví dụ như khi mới bắt đầu tập đi, một đứa trẻ sẽ thử nghiệm và nếu đứng được thì các khớp nối dẫn đến các động tác trước đó sẽ được tăng cường (giá trị tăng - potentiation). Ngược lại, nếu bị ngã, đứa trẻ sẽ cảm thấy đau và các khớp nối dẫn đến các động tác đi không đúng sẽ bị suy giảm giá trị, hoặc mất đi (depression). Học chính là một sự thử nghiệm và lặp lại cho đến khi các khớp nối có được giá trị phù hợp. Rất may mắn là quá trình tiến hóa tự nhiên đã cho chúng ta rất nhiều tri thức chứa trong các giá trị ban đầu của khớp nối thần kinh (được mã hóa qua ADN và đột biến). Các giá trị đó đã rất gần giá trị phù hợp cho việc học đi nên một đứa trẻ chỉ cần thử vài lần, bị ngã vài lần là có thể đi được. Trong khi đó, để "dạy" cho một robot tập đi thì chúng ta cần tạo ra các giá trị khớp nối của mạng neuron của robot từ đầu, thông thường là từ những giá trị khởi tạo ngẫu nhiên. Chúng ta cần truyền rất nhiều dữ liệu cho robot và nó sẽ thử đi - ngã và học nhiều lần với rất nhiều năng lượng tiêu thụ. Chế tạo một robot biết đi "mượt" như con người là việc rất khó mà không nhiều nhóm làm được.

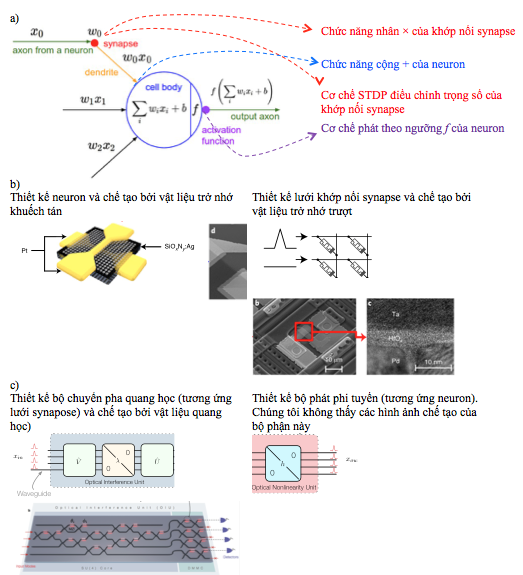

Đến đây chúng ta nhận thấy có một đặc điểm rất đặc biệt của khớp nối - synapse - là nó có khả năng tự điều chỉnh lại giá trị sau khi mà neuron mà nó truyền giá trị đến phản ứng với giá trị trước đó của nó. Đây gọi là cơ chế đàn hồi thời gian (time plasticity) đặc biệt của khớp nối, là cơ chế giúp chúng ta học được. Các hệ thông minh tự nhiên muốn hoạt động cũng cần phải chế tạo được cơ chế này. Nói tóm lại, các hệ thông minh tự nhiên cần có các cấu trúc gồm các neuron và khớp nối liên kết với nhau với 2 chức năng và 2 cơ chế quan trọng nhất (Xem hình 5a):

- Chức năng nhân tín hiệu × của khớp nối với trọng số (điện trở) của nó.

- Chức năng cộng tín hiệu + của neuron.

- Cơ chế đàn hồi thời gian - điều chỉnh được trong số (điện trở) của khớps nối.

- Cơ chế phát tín hiệu theo ngưỡng f của neuron

Những hệ thông minh tự nhiên đầu tiên

Một số nhóm nghiên cứu/start-up đã bước đầu xây dựng được các hệ thông minh tự nhiên, trong đó giải pháp sử dụng vật liệu điện và quang đang có những tiến bộ quan trọng. Chúng tôi mô tả ngắn ngọn thiết kế của 2 nhóm tiêu biểu trong các như sau:

1. Nhóm Đại học Massachuset sử dụng các vật liệu tiên tiến là trở nhớ để chế tạo các neuron trở nhớ và synapse (khớp nối) trở nhớ:

Với neuron, nhóm chế tạo một điện trở với 2 điện cực kim loại áp lên một lớp vật liệu điện môi (SiOxNy hoặc SiOx) được cấy các hạt nano bạc (Ag) tạo thành một linh kiện (điện) trở nhớ. Kết hợp với một tụ điện C, trở nhớ này có thể thực hiện chức năng phát tín hiệu theo ngưỡng f như sau: Khi tín hiệu truyền đến nhiều và đủ lớn, tụ điện và điện trở được tích đủ điện thế và kích hoạt các hạt bạc tạo thành một kênh dẫn điện (một hiệu ứng vật lý phức tạp) và dòng điện truyền qua giúp neuron phát đi tín hiệu. Sau khi phát điện, các hạt bạc khuếch tán trở lại và ngắt kênh dẫn điện, neuron trở về trạng thái đóng ban đầu (xem hình 5b)..

Với synapse (khớp nối), nhóm cũng sử dụng vật liệu trở nhớ với dung môi HfOx kẹp giữa 2 điện cực Pd và Ta tạo thành trở nhớ trượt (drift memristor). Cấu trúc này cho phép thay đổi điển trở của synapse tùy theo giá trị điện thế áp dụng. Các synapse được chế tạo thành một lưới liên kết tín hiệu vào và các neuron đầu ra ở trên. Với cấu trúc trên, tương tác giữa synapse và neuron tạo ra khả năng học của synapse: Khi neuron phát, điện thế trên neuron giảm làm điện thế trên synapse tăng cao, tiếp tục làm cho độ dẫn điện của synapse tăng lên (điện trở giảm đi) và quá trình học được tăng cường. Đây chính là cơ chế đàn hồi thời gian nói trên.

Cuối cùng, chức × của synapse được thực hiện bởi định luật Ohm khi dòng điện đi qua synapse và chức năng + của neuron được thực hiện bởi định luật Kirchoff của lưới synapse. Hệ thống trên đã được thử nghiệm ở độ phân giải nhỏ và cho phép học các chữ cái thông thường.

2. Một nhóm khác từ MIT nay đã spin-off thành công ty Lightelligence (huy động được hơn 10 triệu USD) chế tạo các hệ thông minh tự nhiên với các vật liệu và dụng cụ quang học như sau:

Neuron được chế tạo bởi một bộ biến đổi phi tuyến quang học (optial non-linear unit - ONU) bao gồm các vật liệu hấp thụ bão hòa quang học (optical saturable absorption) cho phép phát tín hiệu theo. Phép cộng của neuron và phép nhân ma trận được thực hiện bởi bộ phân giao thoa quang học (otpical interference Unit - OIU), trong đó phép nhân được chia thành 3 phép nhân của của 2 ma trận unitary và 1 ma trận đường chéo, theo phương pháp SVD ("singular value decomposition). Các phép nhân này được thực hiện bởi bộ chia tách (beamsplitter) và bộ dịch pha quang học (phase shifter). Cuối cùng, cơ chế đàn hồi theo thời gian nhóm thực hiện bên ngoài với sự hỗ trợ của máy tính thông thường tại thời điểm công bố bài báo 2016.

Hai ví dụ trên đã cho thấy các hệ thông minh tự nhiên bao gồm các neuron và synapse là các thực thể vật chất, tương tác dựa trên các quy luật tự nhiên (trường hợp tín hiệu điện là định luật Ohm và Kirchoff) là khả thi và có thể được thương mại hóa trong tương lai gần. Lợi điểm lớn nhất của chúng là tính toán phân tán trên vật liệu, do đó mang lại tốc độ xử lý song song rất nhanh với rất ít năng lượng tiêu thụ. Đây chính là cách tự nhiên hơn mà chúng ta có thể mô phỏng bộ não con người.

Các hệ thông minh tự nhiên có thể thay thế được các hệ AI trên máy tính hiện tại chứ không thay thế được máy tính, do đặc tính quan trọng của chúng là tính biến động cao (không ổn định). Ví dụ cùng một ánh sáng, một hệ quang có thể cho cường độ sáng khác nhau ở hai lần đo các biến động như sự hao mòn của vật liệu, rung động môi trường, ... Với một máy tính, việc tính sai là không thể cho phép. Nhưng với một hệ AI thì sai số lại không quá nghiêm trọng đến độ chính xác của suy luận. Thật vậy, nếu bạn đã từng train một mạng neuron với hơn 10000 trọng số và đạt được một độ chính xác nào đó. Hãy bỏ đi ngẫu nhiên vài thậm chí vài chục trong số (cho giá trị bằng 0), các giá trị của neuron ở lớp ra sẽ khác nhau, nhưng sự tương đối giữa chúng thì không đổi. Ví dụ một mạng có 2 neuron đầu ra thể hiện sự nhận dạng hình ảnh giữa chó và mèo, giá trị neuron nào cao hơn sẽ chỉ ra con vật tương ứng. Khi hình ảnh được đưa vào, giá trị của hai neuron đã chênh lệch đủ lớn nên khi có sai số ở mỗi neuron, chiều chênh lệch vẫn không thay đổi và mạng vẫn nhận dạng tốt. Trong não bộ chúng ta, các khớp nối mất đi, thoái hóa thường xuyên trong suốt cuộc đời nhưng khả năng suy nghĩ của não không thay đổi quá đột ngột (tất nhiên sẽ có trường hợp như khi tai nạn bị mất đột ngột quá nhiều khớp nối cùng lúc, khi đó khả năng tư duy sẽ bị ảnh hưởng do các khớp nối không thể ngay lập tức được thay thế và việc học sẽ tốn thêm khá nhiều thời gian). Do đó các hệ thông minh tự nhiên có tính ổn định cao và có tiềm năng trở thành những cỗ máy thông minh thực sự.

Cơ hội cho Việt Nam?

Việc cần thiết phải có những hệ thông minh tự nhiên như trên đã tạo ra một cơ hội cho Việt Nam theo kịp về công nghệ so với thế giới, về hai khía cạnh. Thứ nhất là về công nghệ sản xuất bộ vi xử lý (chip): nếu sản xuất chip dựa trên mạch điện tích hợp cho máy tính thông thường thì chúng ta đã bị tụt hậu quá xa và khó thương mại hóa thành công. Trong khi đó, hệ thông minh tự nhiên (điện hoặc quang) có thể coi là một chip AI thế hệ mới, hiện mới được nghiên cứu ở phòng thí nghiệm và chưa có sản phẩm thương mại. Thứ hai là về chính AI: nếu sản xuất được chip AI thế hệ mới, chúng ta sẽ có thể triển khai các bài toán AI nhanh hơn rất nhiều lần so với máy tính thông thường hiện nay, ví dụ như "training" hàng triệu bức ảnh trong vài phút. Điều này sẽ giúp cho việc học, thực hành và ứng dụng AI hay AI trên dữ liệu lớn được dễ dàng và phổ cập. Ngoài ra, chip AI thế hệ mới còn hứa hẹn tạo ra những tiến bộ mới trong khoa học tri thức, đưa AI gần với não bộ con người hơn, tạo ra những ứng dụng cao cấp như suy nghĩ, sáng tạo... có thể giúp Việt Nam vươn lên theo kịp trình độ quốc tế và thậm chí có tham vọng dẫn đầu về AI.

Để có được cơ hội đó, chúng ta cần thay đổi cách nhìn AI là một phần mềm chạy trên máy tính (PC). Rất nhiều nỗ lực hiện đang được tập trung cho "phần mềm" này, là những đoạn code thiết kế ra các mạng neuron và thực hiện tính toán trên đó. Chúng ta cần đầu tư thêm vào phần sau của khái niệm trên, tức là các hệ thống vật chất (Vật lý, Hóa học, Sinh học,...) thực hiện AI nhanh hơn, thông minh hơn và không nhất thiết là các máy tính hiện nay. Hướng khả thi nhất theo chúng tôi là các nhà khoa học của ba ngành - khoa học vật liệu, công nghệ nano, trí tuệ nhân tạo - cùng ngồi lại và thiết kế ra các hệ thông minh tự nhiên nói trên. □

-----

1. Chưa tìm được từ Việt hóa tương đương, có thể tạm gọi là "khớp nối"

2. Mô hình này có thể còn đơn giản, não sinh học có thể có những chức năng khác mà tác giả chưa được biết

------------

Tài liệu tham khảo

1. Wang, Z., Joshi, S., Savel’ev, S. et al. Fully memristive neural networks for pattern classification with unsupervised learning. Nat Electron1, 137–145 (2018) doi:10.1038/s41928–018–0023–2

2. Shen, Y., Harris, N., Skirlo, S. et al. Deep learning with coherent nanophotonic circuits. Nature Photon 11, 441–446 (2017). https://doi.org/10.1038/nphoton.2017.93